La IA de Google Aprende a Analizar el Mundo a Través de la Cámara de un Smartphone

En el MWC de Barcelona, Google presentó nuevas características innovadoras para su asistente de IA, Gemini. A partir de marzo, los suscriptores del plan Google One AI Premium podrán transformar sus smartphones en 'ojos' potenciados por IA gracias a dos innovaciones clave: Análisis de Video en Vivo y Compartición de Pantalla Inteligente.

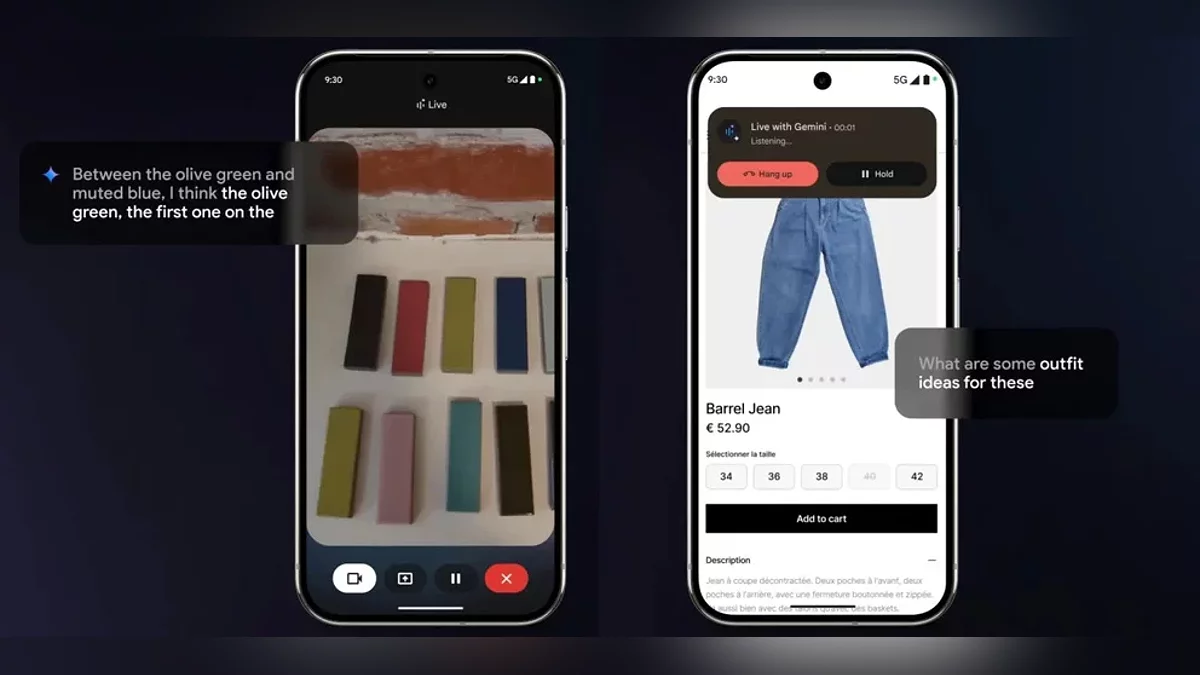

El Análisis de Video en Vivo permite al asistente procesar la entrada de la cámara en tiempo real al instante. Los usuarios pueden apuntar su cámara a una prenda de vestir para obtener consejos de estilo o escanear una habitación para recibir sugerencias de diseño interior. Gemini no solo "ve" lo que hay en la pantalla, sino que participa activamente en el diálogo. Por ejemplo, los usuarios pueden pedirle que optimice una ruta de navegación o aclare un gráfico complejo en una presentación, recibiendo explicaciones en un formato dinámico y conversacional.

Por ahora, estas características están disponibles solo en dispositivos Android con soporte multilingüe. En el stand de Google, la compañía mostró a Gemini funcionando en dispositivos de Samsung, Xiaomi y otros socios, enfatizando la compatibilidad entre marcas. Aún no hay noticias sobre cuándo los usuarios de iOS tendrán acceso.

Las actualizaciones anunciadas son solo un paso hacia el ambicioso proyecto Astra de Google. Para 2025, la compañía tiene como objetivo desarrollar un asistente multimodal universal capaz de:

- Analizar datos de video, audio y texto simultáneamente;

- Mantener el contexto de la conversación durante hasta 10 minutos;

- Integrar datos de Búsqueda, Lens y Maps para soluciones integrales.

Aunque Google no ha anunciado oficialmente Astra como un producto independiente, los expertos especulan que sus características se integrarán gradualmente en Gemini, intensificando la competencia con ChatGPT. Notablemente, OpenAI ha ofrecido un modo de voz expandido con análisis de pantalla desde diciembre de 2023, pero Google está apostando por una integración profunda con su propio ecosistema.

La capacidad de la IA para procesar información visual en tiempo real está difuminando la línea entre los mundos digital y físico. Los usuarios ya no solo interactúan con un "asistente que habla", sino que se involucran con un participante activo en sus tareas diarias, desde comprar hasta aprender. Con el lanzamiento de Gemini Vision, los asistentes de IA están entrando en una era de interacción hipercontextual, donde la pregunta clave cambia de "¿Cómo pregunto?" a "¿Qué muestro?"

Una gran pregunta sigue siendo: la privacidad. ¿Cómo protegerá Google los datos transmitidos a través de la cámara y la pantalla? La compañía asegura que todo el análisis se realiza bajo estrictos estándares de seguridad, pero los detalles completos solo se revelarán una vez que las características se lancen oficialmente.

-

Google Play Protect ahora detecta amenazas en tiempo real con una importante actualización de seguridad

-

Protección Mejorada 2.0: Google Chrome Introduce Defensa Impulsada por IA Contra Amenazas Desconocidas

-

Google lanza la primera beta pública de Android 16

-

Google Ha Lanzado una «Guerra Silenciosa» contra los Bloqueadores de Anuncios: Las Herramientas de Bloqueo de Anuncios Populares Están Fracasando

-

Google Chrome se pone en piloto automático: el navegador ahora reemplaza automáticamente las contraseñas comprometidas